Bonjour tout le monde ! Ca fait très longtemps que je n’ai plus rédigé d’articles malheureusement mais je compte bien me rattraper ;).

Aujourd’hui, je vais vous montrer une technique pour trouver vos propres noms de domaine expirés sans devoir passer par des sites d’enchères comme Kifdom, 4x (actuellement DomRaider) & co. Alors bien évidemment, il n’y a pas mieux que les services de Snapping qui permettent de tracker les noms de domaine qui expireront bientôt mais bon c’est un service payant et je souhaite partager avec vous les étapes qui vous permettront de scrapper le net pour enregistrer gratuitement des noms de domaines expirés sans coût supplémentaire.

A quoi servent les noms de domaines expirés ?

C’est la toute première question à se poser pour les personnes qui ne connaissent rien ou très peu en référencement naturel. Et la réponse est assez simple.

Les expirés ont un fort historique et plus d’autorité qu’un nom de domaine fraîchement acheté. L’intérêt de cette acquisition est avant tout le profit d’un historique et d’un profil de backlinks (liens pointant vers notre site) existant. Nous sommes en 2016 et pourtant, les liens sont toujours un critère de positionnement très lourd dans l’algorithme Google.

En utilisant un nom de domaine expiré, vous sautez plusieurs étapes qui feront que votre site avance très rapidement par rapport à la requête sur laquelle vous souhaitez vous positionner… Un background lourd vous permettra de ranker plus facilement en puisant du jus pré-établi (merci aux anciens proprios des sites). Mais il faut faire en même temps très attention à bien vérifier si le nom de domaine n’est pas spammé et blacklisté !

Recensement des noms de domaine expirés

Nous sommes en train de chercher une information et qui dit recherche dit forcément moteur de recherche. Alors pour ce tutoriel, je vais utiliser Google pour lancer la première étape de notre quête d’expirés.

1. Recherche des sources à scrapper

La première étape est la recherche et le scrap d’URL. Il faudra trouver d’anciennes pages avec pleins de liens pour que nous puissions passer à la prochaine étape. La majorité des personnes cherchent à scrapper des annuaires. C’est ingénieux et surement le moyen le plus simple pour trouver une très grande liste de noms de domaine mais malheureusement, ces sources sont souvent beaucoup scrapper par les SEO. du coup, personnellement, je ne trouve rien du tout sur ces sources ou sinon très peu et très spammy. Donc j’utilise d’autres footprints pour mes recherches.

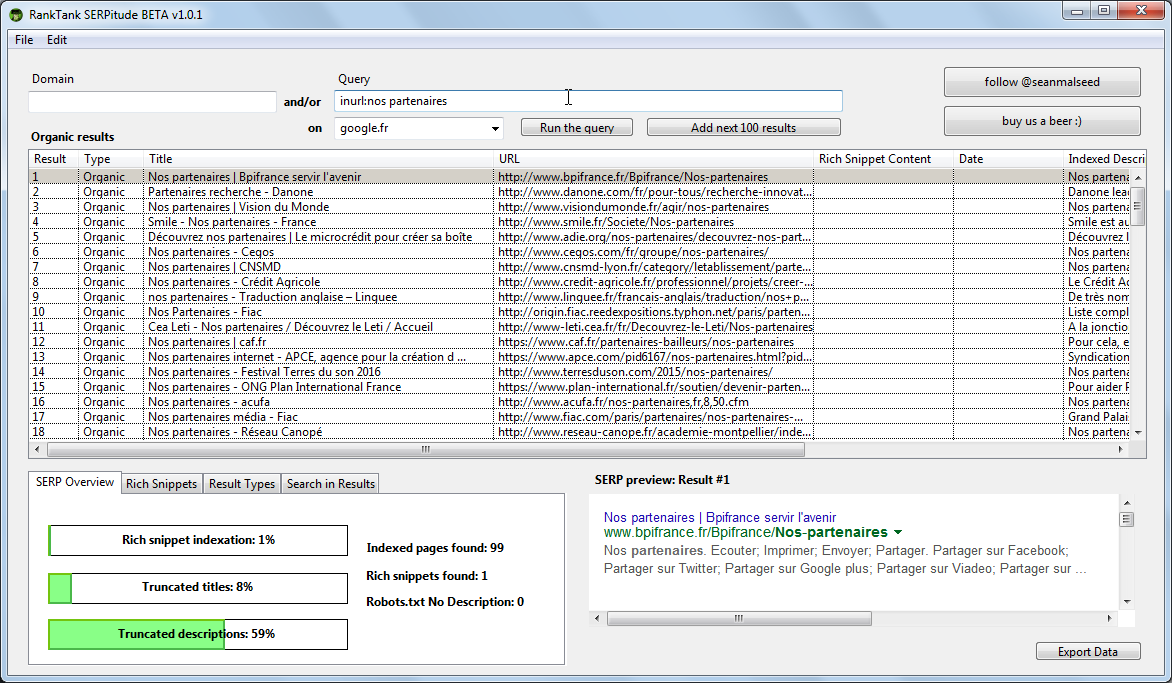

Personnellement, j’utilise Zennoposter et Winautomation pour automatiser tout le processus mais il y a plus d’outils sur le net (ou sinon à la mano) pour lister vos liens à scrapper. Donc je vous propose d’utiliser Serpitude un outil gratuit disponible sur Windows et Mac et qui permet très facilement d’extraire les résultats de recherche Google en deux clics.

Pour cet exemple, j’ai utilisé la requête “Nos partenaires” sur Google FR pour scrapper les liens comme vous pouvez le voir. Il suffit ensuite de cliquer sur le bouton “Export Data” pour extraire les informations.

Il faudra ouvrir ce fichier sur Excel ou tout autre tableur pour copier le contenu de la colonne “D”

Cette étape est la plus importante dans tout le processus. Il faudra utiliser votre imagination pour trouver la requête qui vous permettra d’extraire le max de donnée et surtout sur laquelle vous êtes sûr de trouver des expirés.

Petite astuce : vous pouvez jouer aussi avec le filtre “Date” sur Google 😉

Tester la réponse des serveurs

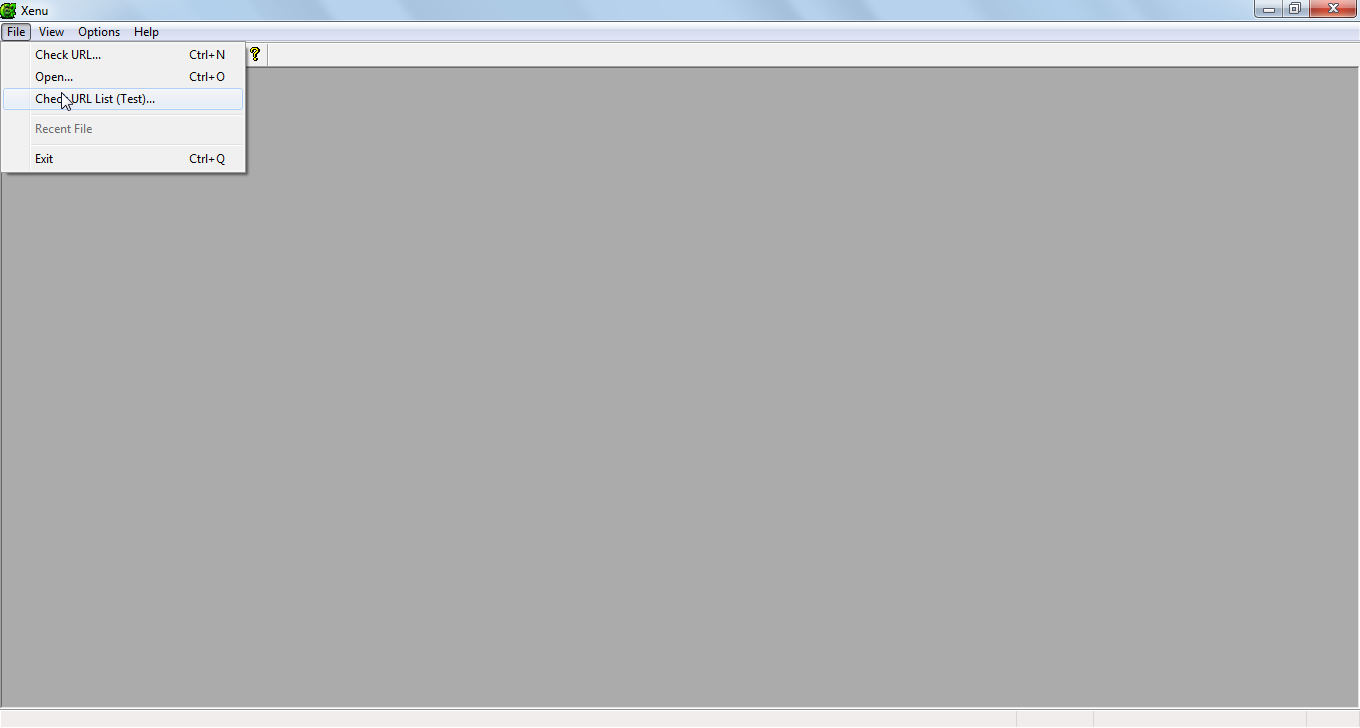

Nous allons ici, tester la réponse des serveurs de tous les liens retrouvés dans les URLS scrappées via Google et pour ce faire nous aurons besoin d’un outil qui facilite cette tâche : Xenu.

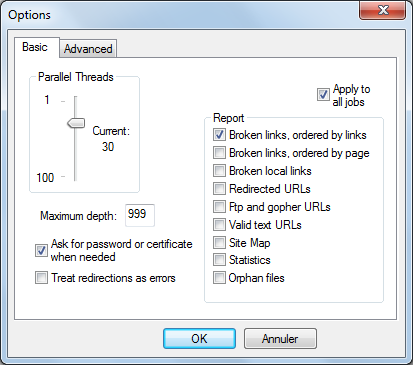

Il faut avant toute chose configurer Xenu pour qu’il n’affiche que la réponse du serveur qui nous intéresse comme suit (Options puis Preferences) :

Assurez-vous aussi de cocher “View” puis “Show broken links only”

Naviguez ensuite vers File, puis sur “Check URL List” et choisissez le fichier d’URL scrappé dans l’étape précédente.

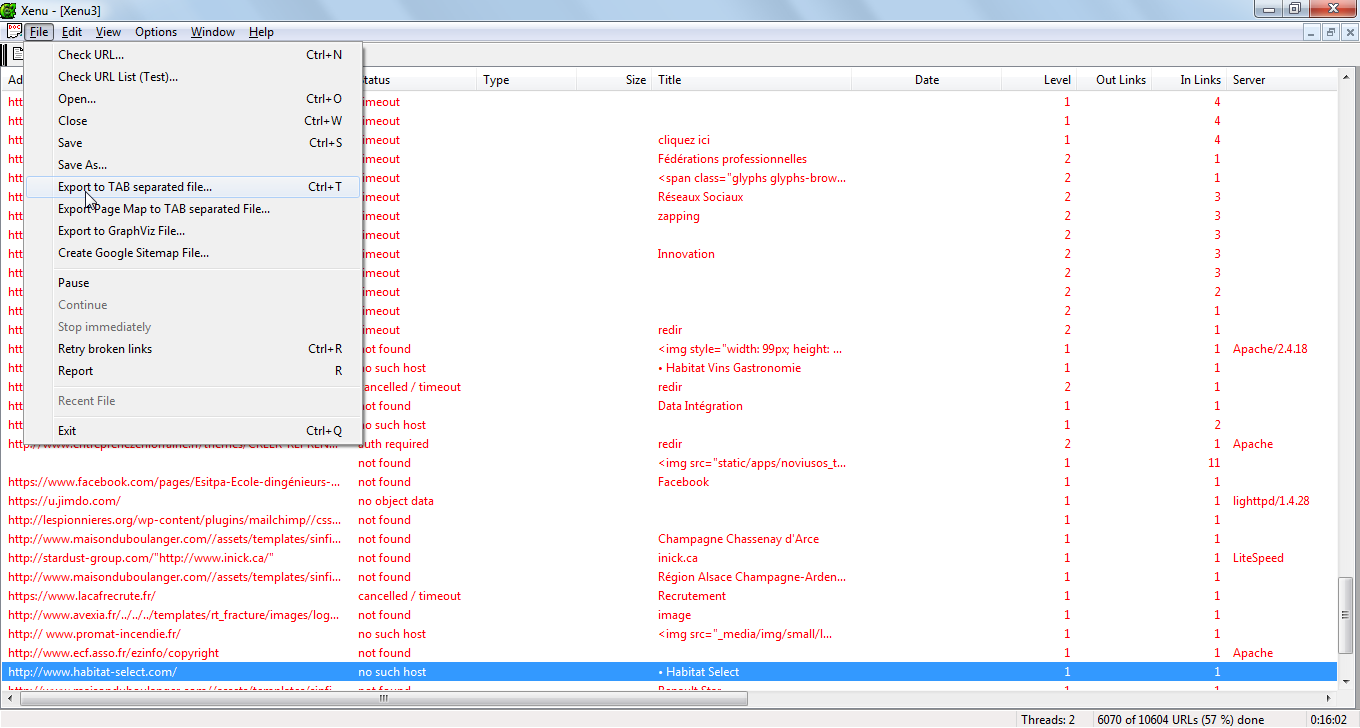

Et laissez le tool faire sa magie. Ca peut durer plusieurs heures selon le nombre de liens scrappé ainsi que le nombre de liens retrouvés sur les liens scrappés.

Filtrer les résultats Xenu

Exportez vos données en navigant vers File puis Export to Tab separated file ou utilisez tout simplement CTRL + T

Cette étape est très simple, il suffit de filtrer nos résultats pour ne prendre que les noms de domaine qui ont une réponse “No such host” ou l’erreur ” 12007 “. J’utilise mon tableur favori Open Office pour effectuer ce filtre. Vous pouvez bien évidemment utiliser n’importe quel autre outil qui peut faire l’affaire.

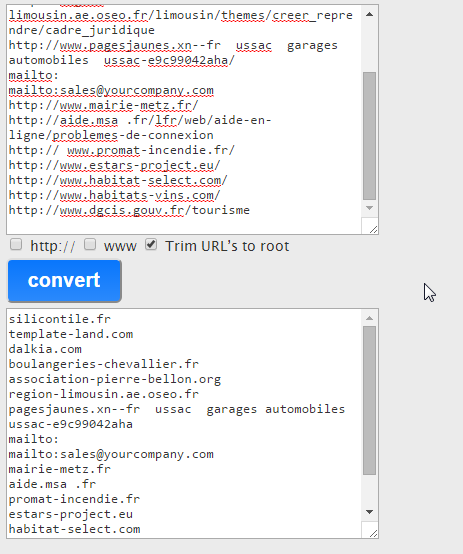

Une fois notre liste de noms de domaine filtré, il faudra faire un TRIM en bulk pour ne laisser que la racine des noms de domaine. J’utilise personnellement ce petit utilitaire quand je fais ceci manuellement sinon j’utilise la fonction TRIM sur Zennoposter en automatisation.

Vérifier la disponibilité et des métriques des noms de domaine

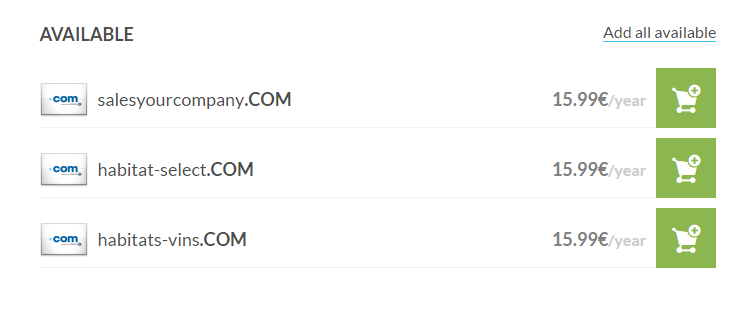

Pour ce faire, j’utilise le site EuroDNS pour faire un bulk test sur la liste que nous venons d’extraire et lister.

Bingo ! Voici 3 expirés dénichés gratuitement ^^

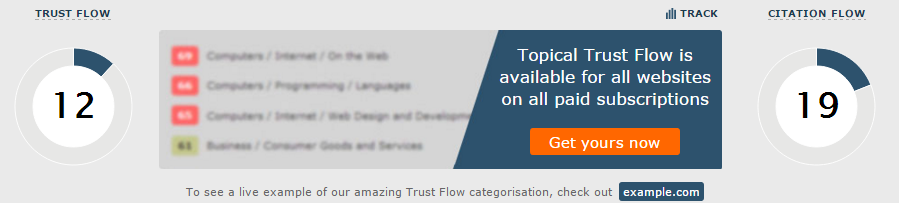

Voilà, la toute dernière étape est la vérification des métriques des noms de domaine retrouvés. Je préfère celles de Majestic mais rien ne vous empêche d’utiliser Ahref ou autre…

Habitat-select[dot]com – TF 12 / CF 19 / 8 DR

Habitats-vins[dot]com – TF 8 / CF 19 / 1 DR

Salesyourcompany[dot]com – pas de métriques 😀

J’espère que vous guidera par rapport à vos recherches d’expirés et n’hésitez pas à poser vos questions dans la partie commentaire du blog. Et partagez surtout ha ha :P.

Merci pour l’astuce, moi j’utilisais expireddomains.net le problème c’est que ça ne fait la mise à jour qu’une fois par jour et qu’il faut être rapide si jamais on trouve un bon domaine, la plupart ne sont pas vraiment intéressant, est ce que tu connaitrais un moyen simple pour trouver le nombre de backlinks de plusieurs sites à partir d’un fichier texte?

La majorité des personnes automatisent à 100% cette démarche donc ça devient très difficile de rivaliser avec des robots.

Pour le nombre de BL, tu peux utiliser un service gratuit comme mschecker (mais qui déconne depuis quelques semaines) ou directement le bulk checker intégré de Majestic si tu as un abonnement Silver… Et tu peux automatiser ce processus facilement avec iMacros ou Zennoposter.